โครงข่ายประสาทเทียม (ต่อ)

ในที่นี้ f

-

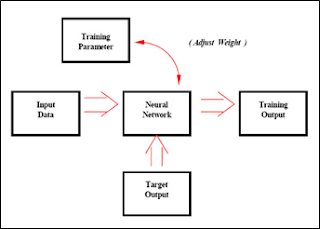

การเรียนรู้สำหรับ Neural

Network

-

Supervised Learning การเรียนแบบมีการสอนเป็นการเรียนแบบที่มีการตรวจคำตอบเพื่อให้วงจรข่ายปรับตัว

ชุดข้อมูลที่ใช้สอนวงจรข่ายจะมีคำตอบไว้คอยตรวจดูว่าวงจรข่ายให้คำตอบที่ถูกหรือไม่

ถ้าตอบไม่ถูก วงจรข่ายก็จะปรับตัวเองเพื่อให้ได้คำตอบที่ดีขึ้น (เปรียบเทียบกับคน

เหมือนกับการสอนนักเรียนโดยมีครูผู้สอนคอยแนะนำ)

ภาพ แสดงการเรียนรู้แบบมีการสอน (Supervised

Learning)

-

Unsupervised Learning การเรียนแบบไม่มีการสอนเป็นการเรียนแบบไม่มีผู้แนะนำ

ไม่มีการตรวจคำตอบว่าถูกหรือผิด

วงจรข่ายจะจัดเรียงโครงสร้างด้วยตัวเองตามลักษณะของข้อมูล ผลลัพธ์ที่ได้

วงจรข่ายจะสามารถจัดหมวดหมู่ของข้อมูลได้ (เปรียบเทียบกับคนเช่น การที่เราสามารถแยกแยะพันธุ์พืช

พันธุ์สัตว์ตามลักษณะรูปร่างของมันได้เองโดยไม่มีใครสอน)

ภาพที่ 43 แสดงการเรียนรู้แบบไม่มีการสอน Unsupervised

Learning

-

สถาปัตยกรรม

บางครั้งพิจารณาจำนวนของเลเยอร์

เพื่อเป็นส่วนหนึ่งของ สถาปัตยกรรม ส่วนการพิจารณาอื่นจะพิจารณาถึงจำนวนเลเยอร์ และโหนดในแต่ละเลเยอร์เพื่อเป็นคุณสมบัติของ

Network แทนที่จะเป็นส่วนหนึ่งของสถาปัตยกรรม ซึ่ง Neurons

processing element ประกอบด้วย

-

Input connection มี input value ซึ่งรับจากทั้ง neuron

ก่อนหน้านี้ หรือ ในกรณีที่เป็น input layer จากภายนอก

- Bias ไม่เชื่อมต่อไปยัง

neuron อื่น ใน network และถูกสมมุติให้มี

input value เป็น 1 สำหรับ การรวมผล

- Weight เป็นตัวเลขที่แสดงความสำคัญของ input เชื่อมต่อไปยัง

neuron แต่ละ neuron input ประกอบด้วย bias

และมีการรวม weight

- State function รูปแบบทั่วๆไปเป็นงานสำหรับรวมผล summation function

ผลลัพธ์ของ state function กลายเป็น input สำหรับ transfer function

- Transfer function

Nonlinear mathematic function ใช้ในการเปลี่ยนข้อมูลเป็น specific

scale มี 2 รูปแบบพื้นฐานของ Transfer

function คือ continuous และ discrete โดยทั่วไป Ramp, Sigmoid,

Arc Tangent และ Hyperbolic Tangent ใช้

continuous function และ continuous

function บางครั้งเรียกว่า squashing function โดยทั่วไป Step และ Threshold ใช้

discrete function และ discrete Transfer function บางครั้งเรียกว่า activation

function

- Training

เป็นกระบวนการใช้ตัวอย่างเพื่อพัฒนา

neural network ที่รวมรูปแบบของ input ด้วยคำตอบที่ถูกต้อง กลุ่มของตัวอย่างที่มี output ที่รู้จักถูกส่งไปยัง

network ซ้ำๆกันเพื่อ train ระบบ network กระบวนการ training จะเป็นไปอย่างต่อเนื่องจนกระทั่งความแตกต่างระหว่าง

input และ output

pattern สำหรับ training set ได้ค่าที่ยอมรับ

มีการใช้วิธีการหลายๆอัน สำหรับ training network

ที่รู้จักกันทั่วไปคือ Back-propagation ซึ่ง Back-propagation

จะทำงานสำเร็จภายใน 2 ขั้นตอน เริ่มแรก input ถูกส่งไปข้างหน้าผ่าน

network เพื่อผลิต output

ต่อจากนั้นความแตกต่างระหว่างเอาพุตจริงๆ กับเอาพุตที่ต้องการจะสร้างสัญญาณผิดพลาด

ซึ่งส่งค่ากลับ ผ่านเครือข่ายเพื่อปรับปรุง ค่าน้ำหนักของอินพุต

Comments

Post a Comment